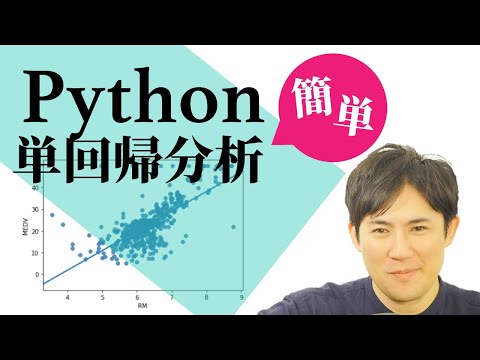

最小二乗法アルゴリズム解説とPython実装!初心者向け

最小二乗法は、データの線形関係をモデル化する際によく使用される手法です。このアルゴリズムは、観測データとモデルの予測値の二乗誤差の合計を最小化することにより、最適なモデルパラメータを見つけることができます。本記事では、最小二乗法の基本概念から、Pythonを使用した実装方法まで、初心者向けに詳しく解説します。そして、具体的なコード例を用いて、このアルゴリズムの動作原理と利点を理解できるようにします。最小二乗法について初めて学ぶ方にも、この記事が役立つことでしょう。

最小二乗法アルゴリズムとは?

最小二乗法(さいしょうにじょうほう)は、データの誤差を最小にするようにパラメータを推定するための手法です。この方法は、線形回帰や多変量解析など、統計学や機械学習の多くの分野で使用されています。最小二乗法の主な目的は、観測データと予測値の差(誤差)の二乗和を最小化することです。

最小二乗法の基本的な考え方

最小二乗法の基本的な考え方は、観測値と予測値の差(誤差)の二乗和を最小化することです。これを数学的に表現すると、以下のような式になります。 [ text{误差の二乗和} = sum {i=1}^{n} (y i – hat{y} i)^2 ] ここで、( y i ) は 観測値、( hat{y} i ) は 予測値 です。この式を最小化するためのパラメータ(通常は回帰係数)を求めることで、最適なモデルを得ることができます。

Hayaemonの使い方を詳細説明!音楽学習を効率化最小二乗法の数式の導出

最小二乗法の数式を導出するためには、線形回帰モデルを考えてみましょう。線形回帰モデルは以下の形式で表現されます。 [ y = beta 0 + beta 1 x + epsilon ] ここで、( y ) は 目的変数、( x ) は 説明変数、( beta 0 ) は 切片、( beta 1 ) は 傾斜、( epsilon ) は 誤差項 です。最小二乗法では、以下の誤差の二乗和を最小化します。 [ S = sum {i=1}^{n} (y i – (beta 0 + beta 1 x i))^2 ] この式を最小化するためには、( S ) を ( beta 0 ) と ( beta 1 ) について偏微分し、それらを0に設定します。 [ frac{partial S}{partial beta 0} = -2 sum {i=1}^{n} (y i – beta 0 – beta 1 x i) = 0 ] [ frac{partial S}{partial beta 1} = -2 sum {i=1}^{n} (y i – beta 0 – beta 1 x i) x i = 0 ] これらの式を解くことで、最適な ( beta 0 ) と ( beta 1 ) を得ることができます。

Pythonでの最小二乗法の実装

Pythonでは、最小二乗法を実装するためのライブラリが多数存在します。最も一般的に使用されるのは `numpy` と `scikit-learn` です。以下は、`numpy` を使用して最小二乗法を実装する簡単な例です。 python import numpy as np データの準備 x = np.array([1, 2, 3, 4, 5]) y = np.array([2, 3, 5, 7, 11]) 1列目に1を追加して切片を計算できるようにする X = np.vstack([np.ones(len(x)), x]).T 最小二乗法のパラメータを計算 beta = np.linalg.inv(X.T @ X) @ X.T @ y 切片と傾斜を表示 print(f’切片: {beta[0]}, 傾斜: {beta[1]}’) このコードでは、データ行列 ( X ) に1列目として1を追加し、`np.linalg.inv` を使用して逆行列を計算し、最小二乗解を求めています。

最小二乗法の応用例

最小二乗法は、多くの応用例があります。以下にいくつかの例を挙げます。 1. 線形回帰: 一番簡単で一般的な応用例です。 2. 多変量回帰: 複数の説明変数を扱います。 3. 非線形回帰: 線形でない関数を近似します。 4. 時間系列分析: 過去のデータから未来の値を予測します。 5. 信号処理: ノイズの除去や信号の復元に使用されます。

最小二乗法の利点と欠点

最小二乗法には、以下の利点と欠点があります。 利点 1. 単純さ: 理解しやすく、実装が簡単です。 2. 効率性: 計算量が比較的少なくて済みます。 3. 広範な応用: 統計学や機械学習の多くの分野で使用されています。 欠点 1. 外れ値の影響: 外れ値に敏感で、結果が大きく変化することがあります。 2. 線形性の仮定: 線形の関係が前提であり、非線形なデータには適していない場合があります。 3. 多重共線性: 説明変数間に強い相関があると、推定が不安定になります。 テーブル

無料で利用できる懸賞アプリを徹底解説!選び方| 項目 | 説明 |

|---|---|

| 利点 |

|

| 欠点 |

|

よくある質問

最小二乗法とは何ですか?

最小二乗法(さいしょうにじょうほう)は、データのフィッティングに使用される一般的な手法です。この方法では、測定データとモデルの予測値の差の二乗和を最小化するように、モデルのパラメータを決定します。最小二乗法は、直線、多項式、およびより複雑なモデルのフィッティングに広く使用されています。この手法は、測定誤差が正規分布に従う場合に、最尤推定と一致することが知られています。

Pythonで最小二乗法を実装する方法は?

Pythonで最小二乗法を実装するには、主にNumpyやScipyなどのライブラリを使用します。例えば、`numpy.polyfit`を使用して線形回帰を行うことができます。また、より複雑なモデルの場合には、`scipy.optimize.curve fit`が役立ちます。これらの関数は、データとモデルの形式を指定するだけで、最小二乗法に基づいて最適なパラメータを計算してくれます。具体的には、データを準備し、関数を呼び出してフィットを行い、結果を可視化するという手順を踏みます。

最小二乗法の利点と欠点は?

最小二乗法の利点は、そのシンプルさと汎用性にあります。この方法は、線形モデルだけでなく、多項式や非線形モデルにも適用でき、多くの実用的な問題を解くことができます。また、数学的な基礎が堅固で、解析的な解決方法が存在するため、理解しやすいという特徴もあります。一方、欠点として、データに外れ値が存在する場合に感度が高くなることが挙げられます。外れ値の影響を減らすために、重み付け最小二乗法やロバスト回帰などの変種が開発されています。

最小二乗法を用いたモデルの評価方法は?

最小二乗法で求めたモデルの評価は、主に決定係数(R²)や平均二乗誤差(MSE)を使用します。決定係数は、モデルの説明力の指標で、1に近いほどモデルがデータをよく説明していることを示します。平均二乗誤差は、予測値と実際の値の差の二乗の平均を計算し、値が小さくなるほどモデルの精度が高くなります。さらに、交差検証(Cross-Validation)を用いて、モデルの汎化能力を評価することも重要です。これにより、訓練データに過学習していないことを確認できます。

Hinemos統合監視システム導入手順と設定方法を解説